チャットGPTの医療への応用は慎重にも慎重であって欲しい

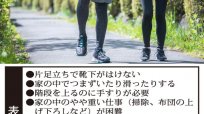

AIの情報が必ずしも信頼できるものではないことが一番の問題だと思います。標準的な治療ガイドラインで、同じがん、同じステージでも、個々の患者によって選択肢が違うことはたくさんあります。それぞれの患者の、置かれたいろいろな状況で違ってくる場合もあるのです。

人間は、安易な方向に行きたがることがあるので、AIの進歩によって物事を深く考えることが少なくなるのではないでしょうか。さらに、「心」の問題にはどう関わってくるのでしょう?

チャットGPTが書く小説はどうなのだろうか。何か、ますます機械に支配され、人間の個性を失っていくような気がしてしまうのです。

考えて考えてつくられたであろうチャットGPTについて、「面白い」「冷静に情報を見て、自分との間隔を空けて考えた方がいい」との意見も聞きます。これからさらにバージョンアップして、人間社会ではどのような存在になっていくのでしょうか。歴史的に見れば、チャットGPTは大きな産業革命となるのでしょうが、個人情報などの問題もあり、医療への応用は慎重にも慎重であって欲しいと思います。

「医療AIプラットフォーム技術研究組合」という組織が出来ています。また、「日本医師会AIホスピタル推進センター」も設置されました。医療のより安心・安全な提供に、たくさん議論していただきたいと思います。